Resumen

FlashBlade//EXA is the newest member of the FlashBlade family. Optimized for AI workloads, this ultra-scale data storage platform provides massive storage throughput and operates at extreme levels of performance and scale.

Los corredores pueden arrancar sus motores. Pure Storage se complace en anunciar FlashBlade//EXA™, una plataforma de almacenamiento de datos a gran escala optimizada para cargas de trabajo de AI al proporcionar un rendimiento de almacenamiento masivo y operar a niveles extremos de rendimiento y escalabilidad.

¿Qué tienen en común los fabricantes de automóviles de alto rendimiento y Pure Storage? Al igual que los fabricantes de automóviles de primer nivel diseñan modelos de automóviles de carrera de vanguardia que superan los límites de velocidad y eficiencia, FlashBlade//EXA está diseñado para ofrecer un rendimiento del siguiente nivel para cargas de trabajo de AI y HPC. FlashBlade//EXA es similar a esos ejemplos en que es un sistema FlashBlade® con Purity//FB altamente optimizado para proporcionar un rendimiento de siguiente nivel para las cargas de trabajo de AI más exigentes. Complementa los modelos FlashBlade//S™ de alto rendimiento y FlashBlade//E™ de alta densidad que han sido probados en el mercado empresarial y reconocidos en el Cuadrante Mágico de Gartner®™ por las plataformas de almacenamiento de objetos y archivos como líderes por cuatro años consecutivos.

El desafío comercial de los rápidos avances en AI

A medida que la innovación de AI se expande, muchas empresas están descubriendo rápidamente valor en aumentar o revolucionar sus operaciones existentes con capacitación e inferencia de modelos. Este crecimiento acelerado ha aumentado la adopción de flujos de trabajo de AI en el procesamiento previo, la capacitación, las pruebas, el ajuste y la implementación, cada uno de los cuales se beneficia de GPU más potentes y conjuntos de datos multimodales más grandes.

Esta expansión también introdujo nuevos desafíos de infraestructura. La escalabilidad del almacenamiento heredado, el control, la administración y las limitaciones de rendimiento de metadatos a escala están creando cuellos de botella y dificultando la utilización total de infraestructuras costosas orientadas a GPU y ralentizando el progreso y la innovación. Esto afecta en gran medida las presiones financieras agresivas del ROI de la AI: cualquier infraestructura dedicada a ella debe ejecutarse con el máximo rendimiento para garantizar el tiempo de obtención de valor más rápido posible para el entrenamiento y la inferencia de modelos. El tiempo perdido es dinero perdido.

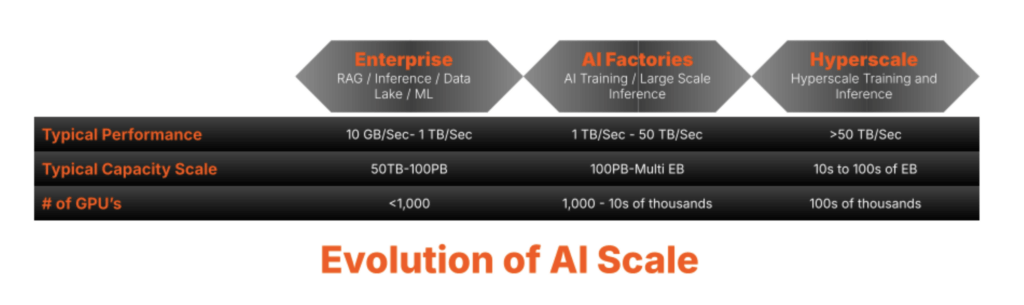

Los desafíos comerciales se amplifican con flujos de trabajo de AI a gran escala

Este desafío comercial de las GPU inactivas que equivale a tiempo y dinero perdidos se amplifica exponencialmente a escala, por ejemplo, proveedores de nube de GPU y laboratorios de AI, por dos razones. En primer lugar, la eficiencia operativa masiva a escala es fundamental para su rentabilidad y va mucho más allá de lo que administran la mayoría de las operaciones de centros de datos en las instalaciones/internas. Un blog que publicamos el año pasado ofreció información sobre cómo piensan los proveedores de servicios y cómo la automatización y la estandarización brutal son fundamentales para sus operaciones. En segundo lugar, los proveedores de servicios se suscriben al principio central de evitar que los recursos funcionen inactivos. Para ellos, las GPU inactivas en cualquier modelo de AI son una oportunidad de pérdida de ingresos; las ineficiencias de almacenamiento en su nivel de operaciones pueden ser perjudiciales.

Las arquitecturas de almacenamiento tradicionales de alto rendimiento se han construido en sistemas de archivos paralelos y se diseñaron y optimizaron para entornos tradicionales de computación de alto rendimiento (HPC, High Performance Computing). Las cargas de trabajo de HPC son predecibles, por lo que los sistemas de almacenamiento paralelos podrían optimizarse para escalar el rendimiento específico. Los flujos de trabajo y modelos basados en AI a gran escala son diferentes de los HPC tradicionales porque son más complejos, e implican muchos más parámetros que también son multimodales, incluidos archivos de texto, imágenes, videos y más, todos los cuales deben ser procesados simultáneamente por decenas de miles de GPU. Estas nuevas dinámicas están demostrando rápidamente cómo los enfoques de almacenamiento tradicionales basados en HPC tienen dificultades para desempeñarse a mayor escala. Más específicamente, el rendimiento de los sistemas de almacenamiento paralelo tradicionales se vuelve contencioso con el servicio de metadatos y datos asociados desde el mismo plano del controlador de almacenamiento.

Este cuello de botella emergente requiere un nuevo pensamiento para la administración de metadatos y las optimizaciones del acceso a datos para administrar de manera eficiente diversos tipos de datos y una alta concurrencia de cargas de trabajo de AI a escala del proveedor de servicios.

Requisitos de escalabilidad de almacenamiento extremo con la evolución de la carga de trabajo de AI

A medida que aumentan los volúmenes de datos, la administración de metadatos se convierte en un cuello de botella crítico. El almacenamiento heredado tiene dificultades para escalar los metadatos de manera eficiente, lo que lleva a la latencia y la degradación del rendimiento, especialmente para las cargas de trabajo de AI y HPC que exigen un paralelismo extremo. Las arquitecturas tradicionales, diseñadas para el acceso secuencial, no pueden seguir el ritmo. A menudo sufren de rigidez y complejidad, lo que limita la escalabilidad. Superar estos desafíos requiere una arquitectura que priorice los metadatos y que se escale sin problemas, admita el paralelismo masivo y elimine los cuellos de botella. A medida que evoluciona la oportunidad de AI y HPC, los desafíos solo se agravan.

El núcleo de metadatos comprobado disponible en FlashBlade//S ha ayudado a los clientes empresariales a abordar los exigentes requisitos de capacitación, calibración e inferencia de AI al superar los desafíos de los metadatos, como los siguientes:

- Administración de la concurrencia: Manejar volúmenes masivos de solicitudes de metadatos en varios nodos de manera eficiente

- Prevención de hotspots: Evitar los cuellos de botella de un solo servidor de metadatos que pueden degradar el rendimiento y requerir ajustes y optimizaciones continuas.

- Coherencia a escala: Garantizar la sincronización entre las copias de metadatos distribuidos

- Administración eficiente de la jerarquía: Optimización de operaciones complejas del sistema de archivos mientras se mantiene el rendimiento

- Escalabilidad y adaptación: Mantener un alto rendimiento a medida que los volúmenes de datos crecen exponencialmente

- Eficiencia operativa: Garantizar que la administración y los gastos generales se minimicen y automaticen para respaldar la eficiencia a escala.

FlashBlade//EXA aborda los desafíos de rendimiento de la AI a escala

Pure Storage tiene un historial comprobado de asistencia a clientes en una amplia gama de casos de uso de alto rendimiento y en cada etapa de su camino hacia la AI. Desde que presentamos AIRI® (Infraestructura lista para la AI) en 2018, hemos continuado liderando con innovaciones como certificaciones para NVIDIA DGX SuperPOD™ y NVIDIA DGX BasePOD™, así como soluciones llave en mano como GenAI Pods. FlashBlade se ha ganado la confianza en el mercado empresarial de AI y HPC, ayudando a organizaciones como Meta a escalar sus cargas de trabajo de AI de manera eficiente. Nuestro núcleo de metadatos se basa en una base de datos transaccional de distribución masiva, y la tecnología de almacenamiento de valor clave ha garantizado una alta disponibilidad de metadatos y una escalabilidad eficiente. Al aplicar los resultados de los hiperescaladores y aprovechar nuestro núcleo de metadatos avanzados probados con FlashBlade//S, Pure Storage tiene la capacidad única de ofrecer un almacenamiento de rendimiento extremo que supera los desafíos de metadatos de la AI y HPC a gran escala.

Ingrese FlashBlade//EXA.

A medida que los flujos de trabajo extremos de AI de extremo a extremo superan los límites de la infraestructura, la necesidad de una plataforma de almacenamiento de datos que coincida con esta escala nunca ha sido mayor. FlashBlade//EXA amplía la familia FlashBlade, lo que garantiza que los entornos de AI y HPC a gran escala ya no estén limitados por las limitaciones de almacenamiento heredadas.

FlashBlade//EXA está diseñado para fábricas de AI y ofrece una arquitectura de procesamiento masivamente paralela que desglosa datos y metadatos, eliminando cuellos de botella y complejidad asociados con los sistemas de archivos paralelos heredados. Desarrollado sobre las fortalezas comprobadas de FlashBlade y con la tecnología de la arquitectura de metadatos avanzada de Purity//FB, proporciona una tasa de transferencia, escalabilidad y simplicidad inigualables en cualquier escala.

Ya sea que admita nativos de AI, técnicos técnicos, empresas impulsadas por AI, proveedores GPU de nube con GPU, laboratorios de HPC o centros de investigación, FlashBlade//EXA cumple con las demandas de los entornos con más uso de datos. Su diseño de próxima generación permite una producción, inferencia y capacitación sin interrupciones, lo que ofrece una plataforma de almacenamiento de datos integral incluso para las cargas de trabajo de AI más exigentes.

Nuestro enfoque innovador sobre cómo modificamos Purity//FB, que implicaba dividir la I/O basada en la red de alta velocidad en dos elementos discretos:

- La matriz FlashBlade almacena y administra los metadatos con su base de datos de clave/valor distribuida con escalabilidad horizontal líder en la industria.

- Un clúster de nodos de datos de terceros es donde se almacenan los bloques de datos y se accede a ellos a muy alta velocidad desde el clúster de GPU a través del acceso remoto directo a la memoria (RDMA, Remote Direct Memory Access) utilizando protocolos de red estándar de la industria.

Esta segregación proporciona acceso a datos sin bloqueo que aumenta exponencialmente en escenarios informáticos de alto rendimiento donde las solicitudes de metadatos pueden igualar, si no superar, las operaciones I/O datos.

¿Por qué servidores y SSD listos para usar para nodos de datos?

Los entornos de AI a gran escala pueden tener una inversión establecida de servidores 1U y 2U con SSD como bloques de construcción de infraestructura. FlashBlade//EXA aprovecha los servidores listos para usar para el plano de datos, lo que facilita la adaptación a la arquitectura del cliente objetivo (en este caso, entornos a gran escala). Esto destaca un punto importante sobre nuestra plataforma de almacenamiento de datos:

*Purity, como corazón de nuestra plataforma, reside en su capacidad de ser modificada para abordar nuevos casos de uso, incluso si significa estirarse para operar fuera de nuestro propio hardware. Resolver los desafíos con nuestro software es un principio fundamental para nosotros porque es un enfoque más elegante y proporciona un tiempo de obtención de valor más rápido para los clientes.

Estos nodos de datos listos para usar ofrecen a los clientes la flexibilidad de adaptarse con el tiempo y pueden ser impulsados por la evolución de los clientes sobre cómo aprovechan el flash NAND en sus centros de datos.

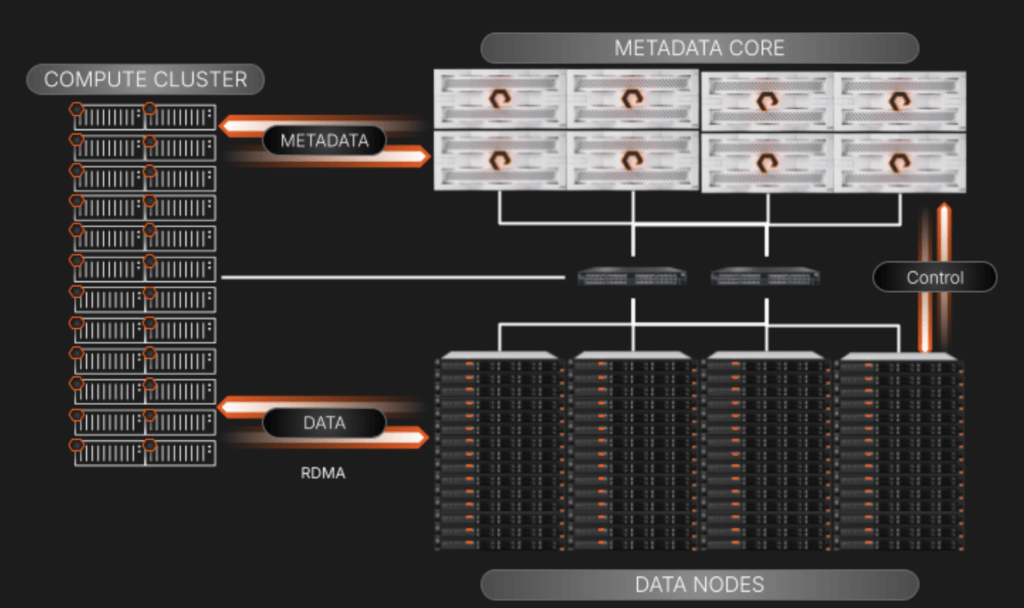

Una vista de alto nivel de los componentes y I/O de FlashBlade//EXA

Al separar los metadatos y los planos de servicio de datos, nos hemos enfocado en mantener los elementos del diagrama anterior simples de escalar y administrar:

- Metadata principales: Esto brinda servicio a todas las consultas de metadatos desde el clúster de procesamiento. Cuando se atiende una consulta, el nodo de procesamiento solicitante se dirigirá al nodo de datos específico para hacer su trabajo. La matriz también supervisa la relación de los nodos de datos con los metadatos a través de una conexión de plano de control que está detrás de escena en su propio segmento de red.

- Nodos de datos de terceros: Estos son servidores estándar listos para usar para garantizar una amplia compatibilidad y flexibilidad. Los bloques de datos residen en las unidades NVMe en estos servidores. Ejecutarán un OS “delgado” basado en Linux y un kernel con administración de volumen y servicios de destino RDMA personalizados para trabajar con metadatos que residen en la matriz FlashBlade//EXA. Incluiremos un manual de estrategias de Ansible para administrar la implementación y las actualizaciones de los nodos para eliminar cualquier inquietud sobre la complejidad a escala.

- Acceso paralelo a los datos mediante el entorno de red existente: FlashBlade//EXA emplea un enfoque elegante que aprovecha una red de núcleo único altamente disponible que utiliza BGP para enrutar y administrar el tráfico entre metadatos, datos y clientes de cargas de trabajo. Este diseño permite una integración sin interrupciones en las redes de clientes existentes, lo que simplifica la implementación de entornos de almacenamiento altamente paralelos. Es importante destacar que todos los protocolos de red aprovechados son estándar de la industria; la pila de comunicaciones no contiene elementos patentados.

Cómo desempacar los desafíos del almacenamiento heredado de alto rendimiento con sistemas de archivos paralelos y modelos desglosados

Muchos proveedores de almacenamiento que apuntan a la naturaleza de alto rendimiento de grandes cargas de trabajo de AI solo resuelven la mitad del problema de paralelismo, lo que ofrece el ancho de banda de red más amplio posible para que los clientes alcancen los objetivos de datos. No abordan la forma en que los metadatos y los datos reciben servicio a una tasa de transferencia masiva, que es donde surgen los cuellos de botella a gran escala. Esto tiene sentido, ya que la intención del diseño de NFS cuando Sun Microsystems lo creó en 1984 era simplemente cerrar la brecha entre el acceso a archivos local y remoto, donde el enfoque del diseño era la funcionalidad sobre la velocidad.

Desafíos de escalar con NAS heredado

El diseño y la escala del NAS heredado prohíben admitir el almacenamiento paralelo debido a su diseño de un solo propósito para prestar servicio a archivos compartidos operativos e incapacidad para escalar I/O de forma lineal a medida que se agregan más controladores.

Desafíos de la escalabilidad con sistemas de archivos paralelos tradicionales

Incluso antes del aumento actual de la AI, algunos proveedores de almacenamiento heredados aprovecharon los sistemas de archivos paralelos especializados como Lustre para ofrecer un paralelismo de alto rendimiento para las necesidades de computación de alto rendimiento. Si bien esto funcionó para varios entornos grandes y pequeños, es propenso a la latencia de metadatos, las redes extremadamente complicadas y la complejidad de la administración, a menudo relegada a los doctores que supervisaban sus arquitecturas de HPC y los costos blandos asociados al escalar a necesidades más grandes.

Desafíos de los datos desglosados y las soluciones de procesamiento

Otros proveedores de almacenamiento han diseñado sus soluciones no solo para confiar en un sistema de archivos paralelos diseñado específicamente, sino también para agregar una capa de agregación de procesamiento entre los clientes de cargas de trabajo y los metadatos y los objetivos de datos:

Este modelo sufre de rigidez de expansión y más desafíos de complejidad de administración que el pNFS al escalar para un rendimiento masivo porque implica agregar más piezas móviles con nodos de agregación de procesamiento. Existe otro desafío potencial: la implementación de funciones de acceso a datos desglosados en este modelo arriesga la latencia inesperada en la pila porque su red se complica mucho más en la administración del direccionamiento, el cableado y la conectividad con tres capas discretas en comparación con lo que se necesita para el pNFS.

Además, a cada nodo de datos y metadatos se le asigna una cantidad fija de caché donde los metadatos siempre se almacenan. Esta rigidez obliga a los datos y metadatos a escalar en forma constante, creando ineficiencias para cargas de trabajo multimodales y dinámicas. Y, a medida que cambian las demandas de carga de trabajo, este enfoque de escalamiento lineal puede provocar cuellos de botella en el rendimiento y un sobreaprovisionamiento innecesario de la infraestructura, lo que complica aún más la administración de recursos y limita la flexibilidad.

También estamos comenzando

Nuestro anuncio de FlashBlade//EXA revoluciona el rendimiento, la escalabilidad y la sencillez de las cargas de trabajo de AI a gran escala. Y recién estamos comenzando.

Comuníquese con su equipo de Pure Storage para obtener más información sobre cómo estamos, una vez más, interrumpiendo el pensamiento convencional en uno de los segmentos de rápido crecimiento de la industria.

Reúnase con nosotros en NVIDIA GTC 2025, del 17 al 21 de marzo. Reserve una reunión.

Explore pure.ai y nuestra página de soluciones de AI para obtener más información.

FlashBlade//EXA

Experience the World’s Most Powerful Data Storage Platform for AI

Join the Webinar

Discover the power of FlashBlade//EXA for AI workloads. April 24, 2005.