Samenvatting

Some newer NVMe-based, software-defined storage (SDS) startups are leveraging commodity off-the-shelf (COTS) SSDs in their solutions. However, using COTS SSDs poses limitations for these vendors and for customers who choose these systems.

Nu quad-level cell (QLC) NAND-flashmedia zijn prevalentie blijven uitbreiden naar opslagsystemen, zien we een grotere kosteneffectiviteit van SSD’s en daarmee een daling van de inzet van traditionele HDD’s. Al dezelfde voordelen die de historische verplaatsing van HDD’s voor meer prestatie-intensieve workloads aanstuurden, worden nu toegepast op alle workloads, gedreven door de dalende $/GB-kosten van QLC-media. Tegelijkertijd heeft de AI-mogelijkheid urgentie gebracht voor ondernemingen die hun data op een operationeel efficiënte manier willen activeren en geld willen verdienen.

Het zwaanlied van HDD’s is begonnen, maar is het op dit moment realistisch om de wake te plannen?

In deze tweedelige aflevering van onze blogserie “Beyond the Hype” bespreken we waarom het gebruik van commodity off-the-shelf (COTS) SSD’s, voorgesteld door enkele nieuwere NVMe-gebaseerde, softwaregedefinieerde opslag (SDS) startups, een suboptimaal alternatief is voor all-flash arrays (AFA’s) die speciaal gebouwde flashopslagapparaten gebruiken om HDD’s te vervangen. In deel 2 komen we tot een meer directe vergelijking tussen COTS SSD’s en Pure Storage® DirectFlash®-modules.

Duurzaamheidskwesties zullen de ondergang van HDD’s bespoedigen

In vergelijking met legacy HDD-opslagsystemen biedt flash-gebaseerde opslag overweldigende voordelen voor alle workloads: superieure prestaties, hogere betrouwbaarheid, verhoogde opslagdichtheid, lager stroomverbruik en lagere operationele overhead. Van 2012 tot 2019 zijn AFA’s populairder geworden en zijn ze nu ongeveer 80% of meer van alle opslagzendingen voor performante applicatieomgevingen aangestuurd.

HDD’s zijn in wezen in het magnetische stof achtergebleven.

Waarom? Naarmate meer ondernemingen duurzaamheid als belangrijke criteria voor nieuwe AFA-aankopen prioriteren, worden statistieken zoals energie-efficiëntie (TB/watt) en opslagdichtheid (TB/U) van cruciaal belang bij het evalueren van de kosten van nieuwe systemen. De hogere dichtheid van SSD’s (in vergelijking met HDD’s) en aanzienlijk hogere prestaties zijn belangrijke factoren die bijdragen aan een betere efficiëntie en uiteindelijk lagere kosten, omdat er veel minder media-apparaten (en veel minder ondersteunende infrastructuur voor die apparaten zoals controllers, behuizingen, ventilatoren, voedingen, kabels, schakelaars, enz.) nodig zijn om een systeem te bouwen om aan bepaalde prestatie- en capaciteitsvereisten te voldoen.

Bij Pure//Accelerate® 2023 hebben we een belang gehecht aan het feit dat 2028 het laatste jaar zou zijn waarin nieuwe opslagsystemen die rond HDD’s zijn gebouwd, zouden worden verkocht voor zakelijk gebruik. Wat verloren ging te midden van de hullabaloo die door die verklaring werd gegenereerd, was dit: De agressieve voorspelling van Pure Storage was gebaseerd op ondernemingen die onze flash-apparaten gebruikten, niet op commodity off-the-shelf (COTS) SSD’s. We zijn optimistisch over flash, maar zelfs we denken niet dat COTS SSD’s dit decennium HDD’s uit zullen rijden.

Er is iets heel anders en innovatiefs aan de manier waarop we bij Pure Storage flash inzetten in onze enterprise-storagesystemen. We weten dit omdat bewezen is dat Pure Storage DirectFlash Modules (DFM’s) twee tot vijf keer beter zijn op elke zinvolle metriek dan die op basis van COTS SSD’s. En ze zijn 10 keer beter dan HDD’s op elke metriek, behalve één: de ruwe aanschafkosten.

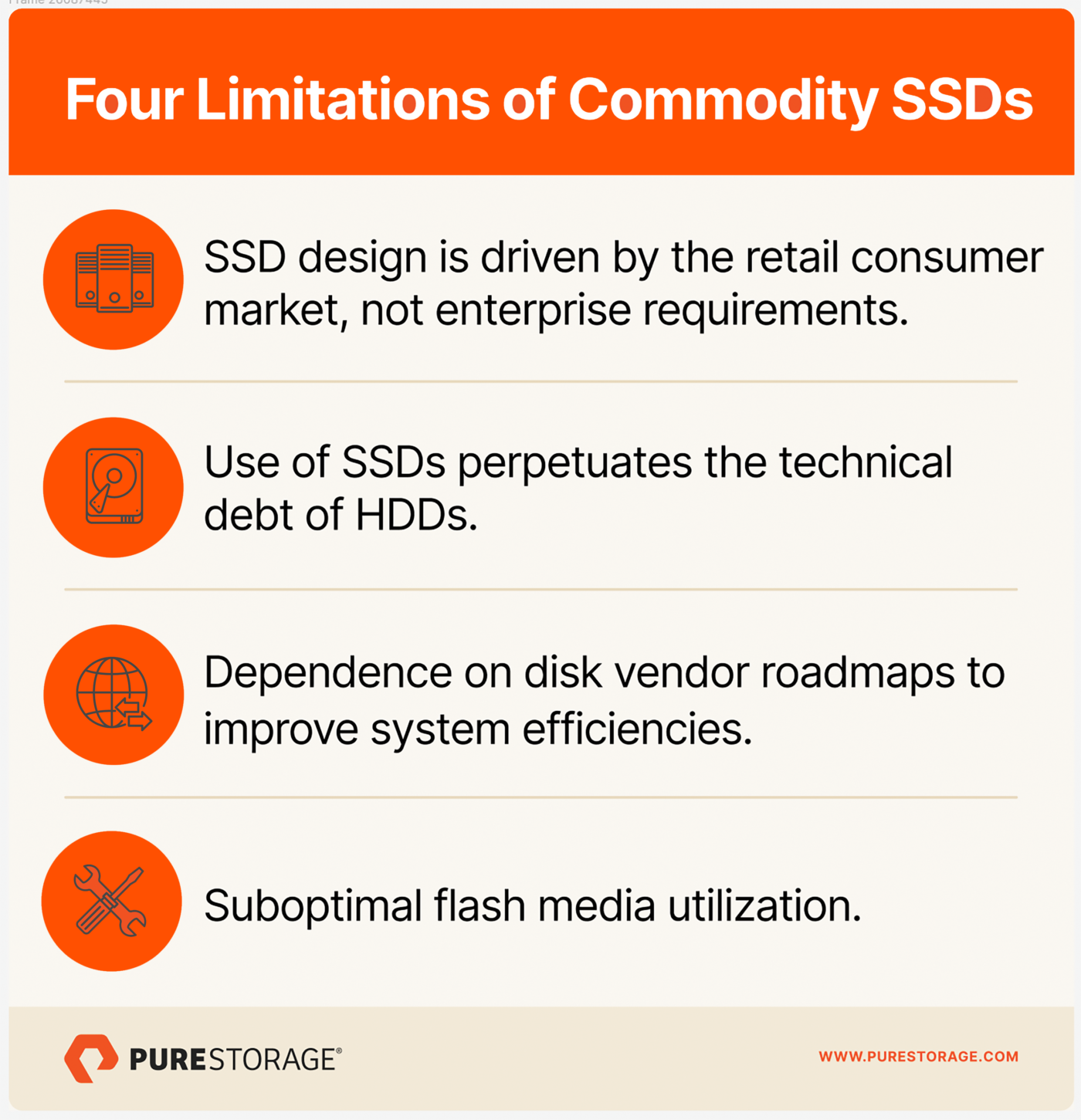

Beperkingen van leveranciers die gebruikmaken van COTS SSD’s

Vier dingen werken tegen leveranciers die COTS SSD’s gebruiken, zelfs als die NVMe-gebaseerd zijn. Laten we elk van hen eens bekijken:

- SSD-ontwerp wordt gedreven door het volume van de retailconsumentenmarkten in plaats van door bedrijfsvereisten.

- Het gebruik van COTS SSD’s bestendigt de technische schuld van HDD’s.

- Het zorgt voor afhankelijkheid van roadmaps van schijfleveranciers om de systeemefficiëntie te verbeteren.

- Het resulteert in suboptimaal gebruik van flashmedia.

SSD-ontwerp wordt gedreven door het volume van de retailconsumentenmarkten in plaats van door bedrijfsvereisten

In de wereld van opslagmedia zijn productiekostenefficiënties direct gecorreleerd met productievolumes. Consument (pc’s en mobiel), niet enterprise, SSD’s vormen de volumemarkt. Bedrijfs-SSD’s vormen in feite slechts ongeveer 15% van de totale SSD-markt. Naar aanleiding van het volume worden belangrijke innovaties voor COTS SSD-technologie gedreven door de consumentenmarkt, die lage kosten en lagere capaciteiten waardeert, niet door bedrijfsvereisten. Omgekeerd waarderen ondernemingen prestaties, duurzaamheid, betrouwbaarheid en data-integriteit – allemaal kenmerken die deep engineering vereisen die verder gaan dan de SSD’s voor de kernconsument. Deze dichotomie blijft de innovatiecyclus voor COTS SSD’s en hun toepassing op bedrijfsmarkten belemmeren.

Het gebruik van COTS SSD’s bestendigt de technische schuld van HDD’s

SSD’s zijn zo ontworpen dat ze gemakkelijk konden worden geplaatst in opslagsystemen die waren ontworpen voor HDD’s. Met name COTS SSD’s zijn grotendeels ontworpen om te passen in 2,5″ Small Form Factor (SFF)-schijfbehuizingen. De meeste AFA’s voor ondernemingen zijn speciaal ontwikkeld om deze COTS SSD’s te gebruiken. Enterprise AFA’s die apparaten gebruiken die in 2,5″ SFF-footprints moeten passen, zijn beperkt in hun vermogen om de dichtheid te verhogen, minder watt/TB te leveren en flashmedia optimaal te gebruiken.

Wat zijn die beperkingen? COTS SSD’s omvatten een interne controller, DRAM voor caching om de prestaties te verbeteren en de flashmedia zelf. Een COTS SSD heeft 1GB DRAM nodig voor elke 1TB flashcapaciteit, voornamelijk om de flash translation layer (FTL) aan te drijven. Het creëren van een SSD met een grotere capaciteit betekent dat u de ruimte binnen het apparaat voor de controller, het DRAM en de flashmedia moet vinden en het apparaat moet koelen. Het wordt steeds moeilijker om dat te kunnen doen en binnen de grenzen van 2,5″ verpakkingen te blijven terwijl de dichtheid toeneemt.

Laten we eerst kijken naar de controller en de daaruit voortvloeiende firmwarevereisten. De SSD’s zelf hebben embedded controllers die logische block-adressering, ruimtebeheer en achtergrondonderhoudstaken afhandelen, evenals de FTL. Ze omvatten ook ingebouwde NAND-flashcontrollers die de directe geheugentoegang tot de NAND regelen. Deze controllers hebben allemaal firmware, en elk enterprise-opslagsysteem kan gemakkelijk honderden SSD’s hebben, dus er is veel firmware. Firmware is een van de twee belangrijkste oorzaken van storingen in AFA’s (waarbij apparaatstoringen zelf de meest voorkomende zijn). Dit doolhof van firmwarecomplexiteit brengt betrouwbaarheidsrisico’s met zich mee.

Als u zich ooit hebt afgevraagd waarom de meeste systeemleveranciers niet aanbevelen om de firmware op SSD-niveau online te upgraden, komt dit door het risico dat daarmee gepaard gaat gezien de firmwarecomplexiteit. Het nettoresultaat hiervan is dat het zeldzaam is voor een onderneming om zelfs een schijffirmware-upgrade te proberen tijdens de nuttige levensduur van een systeem, waardoor het systeem effectief wordt gedelegeerd aan het gebruik van oudere, minder efficiënte schijffirmware die aanvankelijk met het systeem werd meegeleverd. Het zou fijn zijn om firmware gedurende de nuttige levensduur van een systeem zonder onderbreking te kunnen upgraden om de prestaties, het capaciteitsgebruik, de duurzaamheid, de energie-efficiëntie en andere statistieken te verbeteren, maar op systemen die COTS SSD’s gebruiken, gebeurt dat zelden, tenzij dit wordt geforceerd door een soort probleem met de data-integriteit.

Laten we nu eens kijken naar DRAM. DRAM is veel duurder dan NAND-flashmedia, verbruikt veel stroom in vergelijking met de flashmedia zelf en neemt ruimte in beslag in het apparaat dat niet direct bijdraagt aan de bruikbare capaciteit. De hoeveelheid DRAM die nodig is in SSD’s met een grotere capaciteit is een beperkende factor wanneer u in een 2,5″-vormfactor moet passen. En in systemen met honderden SSD’s is dat veel DRAM – die allemaal per GB veel meer energie verbruiken dan de NAND-flashmedia zelf. DRAM is ook onderhevig aan storingen die de betrouwbaarheid van het apparaat beïnvloeden. Grotere SSD’s die meer DRAM vereisen, vergroten de betrouwbaarheidsproblemen van DRAM.

Hoewel een nieuwe aanpak van schijfverpakkingen, aangeduid als Enterprise en Data Center Standard Form Factor (EDSFF) is ontstaan en een iets dichtere opslagcapaciteit mogelijk maakt, wordt het nog steeds beperkt door dezelfde vervelende “HDD-verpakkingsfactoren” en wordt het momenteel uitgedaagd om groter te zijn dan 30,72 TB met behoud van betrouwbaarheid.

Maar is NVMe niet specifiek ontwikkeld voor flash-apparaten? Ja, maar het is voornamelijk ontworpen om de latency te versnellen en de bandbreedte op flashsystemen te vergroten. Op deze metrieken presteert het duidelijk beter dan SAS, maar het heeft veel minder impact op duurzaamheid, betrouwbaarheid, capaciteitsgebruik of energie-efficiëntie bij gebruik met COTS SSD’s die nog steeds worden beheerd door individuele controllers die afzonderlijk werken.

Afhankelijkheid van de roadmaps van schijfleveranciers om de efficiëntie te verbeteren

Een architectuur voor opslagapparatuur op basis van COTS SSD’s betekent dat de leverancier van het opslagsysteem afhankelijk is van de SSD-roadmaps van de schijfleveranciers voor verbeteringen in energie-efficiëntie en opslagdichtheid. In eerste instantie klinkt dit misschien goed – de medialeveranciers kunnen zich richten op het maken van de “beste” SSD’s en de leveranciers van opslagapparatuur die COTS SSD’s in hun systemen gebruiken, kunnen zich richten op het maken van de beste systemen, toch? Laten we het eens van dichterbij bekijken.

Tegenwoordig zijn SSD’s van 15,36 TB beschikbaar in volume, zijn SSD’s van 30,72 TB beschikbaar (maar nog niet in volume, dus de prijzen zijn nog relatief hoog) en staan SSD’s van 61,44 TB op de prijslijst van ten minste één schijfleverancier (hoewel de beschikbaarheid beperkt lijkt en de prijzen hemelshoog zijn). Op marktniveau rijzen de vragen of SSD’s van 30,72 TB de prijsdaling zullen bereiken die gepaard gaat met zendingen met een hoog volume. En er zijn nog meer vragen over de vraag of de 61,44 TB-apparaten ooit die prijsdaling zullen bereiken. Het lijdt geen twijfel dat flashapparaten met een grotere capaciteit een groot verschil maken in de energie-efficiëntie van een opslagplatform, omdat ze het stroomverbruik en het rackruimteverbruik per terabyte verlagen en de mogelijkheid bieden om minder apparaten te kopen om een doel voor prestaties en capaciteit op systeemniveau te bereiken. In theorie verbetert dit ook de betrouwbaarheid, omdat een systeem met minder apparaten ook veel minder ondersteunende infrastructuur nodig heeft (controllers, behuizingen, ventilatoren, voedingen, kabels, schakelaars, enz.).

Het creëren van een SSD met een grotere capaciteit is echter niet alleen een eenvoudige kwestie van het plaatsen van meer flashmedia in het apparaat. Afhankelijk van de vormfactor moet u de controller, DRAM (1 GB per TB) en flashmedia in het pakket plaatsen. Ervan uitgaande dat een leverancier dat kan bereiken, zijn er geldige bedrijfsproblemen over SSD’s van meer dan 15,36 TB in grootte, met name capaciteitsgebruik en schijfrebuildtijden.

Ongeacht de beweringen van schijfleveranciers over het gebruik van capaciteit op apparaatniveau, raden de meeste leveranciers van opslagsystemen niet aan dat u SSD’s in een opslagsysteem vult dat meer dan 60%-70% vol is. (Het is echter nog erger met HDD’s, omdat systeemleveranciers voorstellen om die apparaten niet meer dan 50%-60% vol te vullen.) Dit onvermogen om alle capaciteit van die SSD’s volledig te benutten betekent dat u er meer moet kopen om bepaalde prestatie- en capaciteitsdoelstellingen te bereiken.

Om het capaciteitsgebruik van de flashmedia in elk apparaat te vergroten, kunnen leveranciers een grote cachelaag toevoegen. Deze cache fungeert als een beter presterende schrijfbuffer en de grote grootte stelt hem in staat om write coalescing uit te voeren om het duurzaamheids- en capaciteitsgebruik van de backing flash beter te vergroten dan conventionele systemen. Maar deze aanpak heeft zijn risico’s. De cache bestaat meestal uit extreem high-performance opslag (d.w.z. Optane of SLC NAND-flash) die aanzienlijk duurder is op $/GB-basis en veel meer stroom verbruikt dan QLC NAND-flash. De schrijfprestaties van die cache moeten hoog genoeg zijn om te voorkomen dat het systeem een schrijfklif raakt, omdat het tegelijkertijd nieuwe schrijfbewerkingen opneemt, Metadata verzoekenuitvoert, leesverkeer afhandelt en beheert hoe data wordt gedefaseerd tot goedkopere flashmedia. Wat is precies die high-performance media, wat kost het en waar wordt de write-cli ervaren met verschillende workloads?

De verhouding tussen reads en writes die high-performance media kunnen leveren is een cruciale succesfactor bij het succesvol verwerken van high-performance workloads, en de verhouding van de cache tot de flashmedia zal variëren met de schrijfintensiteit van de workload. Er zijn impact op de prestaties als u niet de juiste verhouding krijgt en de kosten worden beïnvloed door de grote cachegrootte.

Laten we nu eens kijken naar het probleem met de heropbouwtijd. De meeste leveranciers van opslagsystemen implementeren een vorm van in-line, on-disk dataprotectie zoals RAID of erasure coding (EC) om data te beschermen tegen individuele SSD-storingen. In het kielzog van storingen maken ondernemingen zich zorgen over een tweede schijfstoring die zou leiden tot onbeschikbaarheid of verlies van data voordat de heropbouw van de eerste mislukte schijf is voltooid en maken ze zich om die reden zeer zorgen over de heropbouwtijden van de schijf. Wanneer een SSD uitvalt en moet worden vervangen, moeten al die data op dat apparaat opnieuw worden opgebouwd. COTS SSD’s zijn veel sneller dan HDD’s, dus ondernemingen waren comfortabeler met het implementeren van grotere SSD’s. Leveranciers van opslagsystemen geven meestal een heropbouwtijd van 8 tot 12 uur aan voor een SSD van 15,36 TB, terwijl de schatting 25 tot 30 uur zou zijn voor een HDD van die grootte. Maar dit gaat ervan uit dat er niets anders aan de hand is in het systeem. In de praktijk is de heropbouwsnelheid voor een HDD met behulp van een 20-stripe EC-aanpak die normale I/O blijft gebruiken ongeveer 1TB per dag, wat betekent dat de heropbouw van een 24TB HDD meer dan drie weken kan duren. SSD’s kunnen veel sneller opnieuw worden opgebouwd, maar voor apparaten met een grotere capaciteit hebben we het nog steeds over potentieel vele dagen.

Vanwege de bezorgdheid over de heropbouwtijden willen ondernemingen meestal apparaten met kleinere capaciteiten inzetten in systemen die gevoelig zijn voor de beschikbaarheid van data. Dat heeft met name invloed gehad op het vermogen van schijfleveranciers om apparaten van 30,72 TB te verkopen. In feite heb ik klanten 30,72TB-apparaten in systemen zien implementeren en later besluiten over te stappen op 15,72TB- of 7,68TB-apparaten omdat ze niet genoeg van de capaciteit konden gebruiken terwijl ze voldeden aan hun prestatievereisten om ze economisch aantrekkelijk te maken.1 Ik heb ook gezien dat leveranciers 30,72 TB SSD’s bieden om een deal tegen kostprijs te winnen, maar de klant vervolgens om soortgelijke redenen verplaatsen naar SSD’s met een kleinere capaciteit bij de installatie.

Dus met COTS SSD’s maakt een kleiner apparaat zich zorgen over heropbouwtijden, maar leidt dit tot een duurder en mogelijk minder betrouwbaar systeem. Grotere apparaatformaten leiden tot een energie- en ruimtebesparend systeem, maar brengen zorgen over de bruikbaarheid met zich mee. Om redenen van prestaties op schaal en capaciteitsgebruik zijn schijfleveranciers misschien niet eens bereid om de SSD’s met extreem grote capaciteit (75 TB+) te produceren die nodig zijn voor flash om HDD’s in bedrijfsworkloads te vervangen. Dat komt omdat zelfs als leveranciers de apparaten met grotere capaciteit kunnen maken, er nog steeds een vraag is of bedrijven ze daadwerkelijk in productiesystemen gaan gebruiken. En als klanten ze niet vaak kopen, kunnen leveranciers niet tot het hoge volume komen dat nodig is om de prijzen te verlagen. Dat maakt zakelijke klanten dus nog minder geneigd om ze te kopen.

Dat leidt tot wat onze brethren in de vijver zouden kunnen noemen als “een kleverig lont slaan” voor schijfleveranciers en bedrijven, afhankelijk van COTS SSD’s.

Suboptimaal gebruik van flashmedia

Wat betekent het om een systeem te ontwerpen om flashmedia optimaal te gebruiken? Het betekent het verstrekken vanHDD-bagage, het optimaliseren van het systeemontwerp rond een protocol dat speciaal is gebouwd voor flash (NVMe), en het in kaart brengen en beheren van alle flashmedia in een systeem, zowel wereldwijd als rechtstreeks.

Enterprise SSD’s maken gebruik van een kleine controller in elke schijf die de media in alleen dat apparaat beheert, de lees- en schrijf-I/O coördineert met gratis ruimtebeheer en I/O-fouten aanpakt. Dit was in feite de manier waarop HDD’s werden gebouwd en COTS SSD’s op dezelfde manier worden gebouwd. Bij het nemen van beslissingen over mediagebruik heeft de schijfcontroller geen zicht op wat er nog meer in het systeem gebeurt. Bij het optimaliseren van mediabeheer binnen één schijf, wordt het uiteindelijk suboptimaal beheerd vanuit het oogpunt van het systeem. Het resultaat? Hogere write amplificatie, een probleem vanwege problemen met flashduurzaamheid en minder efficiënte afvalverzameling die een impact heeft op de consistentie van de prestaties, vooral wanneer SSD’s vol raken. Om dit te proberen te compenseren, is flash “overprovisioned” (doorgaans met 15%-20%) in de COTS SSD zelf om de prestaties te verbeteren en het uithoudingsvermogen te vergroten. Deze overprovisioning verhoogt natuurlijk de kosten en neemt af van de “bruikbare capaciteit” die een schijf daadwerkelijk kan bieden (aangezien de overprovisioned capaciteit ruimte inneemt, maar alleen zichtbaar is voor de controller van die schijf, niet voor het systeem).

Er zijn nog steeds opslagsystemen op de markt die in feite alleen bijgewerkte versies zijn van systemen die in de jaren negentig en 2000 zijn ontworpen voor HDD’s die nu SSD’s draaien. Er zijn ook nieuwere systemen, waarvan sommige zijn ontworpen rond NVMe, die minder HDD-bagage hebben en efficiënter zijn. De “HDD-bagage” die er nog steeds is met deze NVMe-systemen, is echter dat ze nog steeds apparaten gebruiken die rond het oorspronkelijke HDD-ontwerp zijn gebouwd met een interne controller, DRAM en media die allemaal binnen een HDD-vormfactor moeten passen. En toegang tot schijfmedia via interne schijfcontrollers die geen globaal beeld hebben van wat het systeem doet, brengt uitdagingen met zich mee wanneer men probeert het meeste uit de flashmedia te halen over vele statistieken: prestatieconsistentie, duurzaamheid, betrouwbaarheid, energieverbruik, dichtheid en capaciteitsgebruik.

In SSD’s brengt de interne controller de media in kaart en presenteert deze aan de FTL, die deze vervolgens presenteert aan een opslagcontroller die deze presenteert aan servers met verschillende toepassingen. Een SSD van 15TB die werkt met een bezettingsgraad van 70% biedt iets minder dan 11TB aan bruikbare capaciteit. Dat is beter dan een HDD met een bezettingsgraad van 60% die slechts 9,2 TB aan bruikbare capaciteit zou presenteren vanaf een apparaat van 15TB. Maar hoe verhoudt dit zich tot een systeem dat gebruikmaakt van flash-opslagapparaten (niet COTS SSD’s) die geen consumentenerfgoed hebben en speciaal zijn gebouwd om de prestaties en efficiëntie in bedrijfsomgevingen te verbeteren? Dat is precies wat we bij Pure Storage hebben gedaan met onze DirectFlash Modules (DFM’s), en we zullen deze vraag beantwoorden in deel 2 van deze blog.

Samengevat dwingt het investeren in een opslagsysteem voor ondernemingen dat is gebouwd rond COTS SSD’s klanten om inefficiënte infrastructuur te accepteren die een negatieve invloed op hen heeft op het gebied van prestatieconsistentie, duurzaamheid van media, betrouwbaarheid van apparaten, energieverbruik, opslagdichtheid, capaciteitsgebruik en uiteindelijk systeemkosten. Maar aangezien de vergelijkingspunten voor zoveel van hen all-HDD-systemen zijn, lijken COTS SSD-gebaseerde systemen aantrekkelijk.

Voorbereiding op deel 2

We hebben de implicaties van het gebruik van COTS SSD’s gezien. Voor zoveel enterprise workloads zijn ze veel beter dan HDD’s. Maar wat als een opslagleverancier flash-opslagapparaten zou kunnen bouwen die twee tot vijf keer beter waren dan COTS SSD’s op het gebied van prestatieconsistentie, duurzaamheid, betrouwbaarheid, energieverbruik, dichtheid en capaciteitsgebruik, en die lager waren in $/GB kosten? We zullen dat in deel 2 bekijken.

1Betalen voor de 30% van een SSD van 30TB die u niet kunt gebruiken is duurder dan betalen voor de 30% van een SSD van 7,68 TB die u niet kunt gebruiken, een factor die de aankoop van COTS SSD’s met een grotere capaciteit ontmoedigt.

Geschreven door: