Resumo

Threat Model Mentor GPT is an AI-powered tool created by Pure Storage that automates threat modeling and democratizes cybersecurity expertise.

No mundo atual do desenvolvimento de software hipercompetitivo e acelerado, garantir a segurança não é um luxo, é uma necessidade. No entanto, um dos componentes mais críticos do design de sistemas seguros, a modelagem de ameaças, permanece fora do alcance de muitas equipes devido à sua complexidade e à experiência especializada que ela exige.

Na Pure Storage, imaginamos usar a capacidade personalizada de GPT da OpenAI para criar uma “GPT de mentor de modelo de ameaça” para preencher essa lacuna. Desenvolvida para simplificar e democratizar a modelagem de ameaças, essa ferramenta com inteligência AI capacita as equipes a identificar, avaliar e mitigar riscos de segurança no início do ciclo de vida do desenvolvimento. Veja a história de como o construímos e como ele está revolucionando o desenvolvimento seguro de software.

Entendendo o espaço do problema

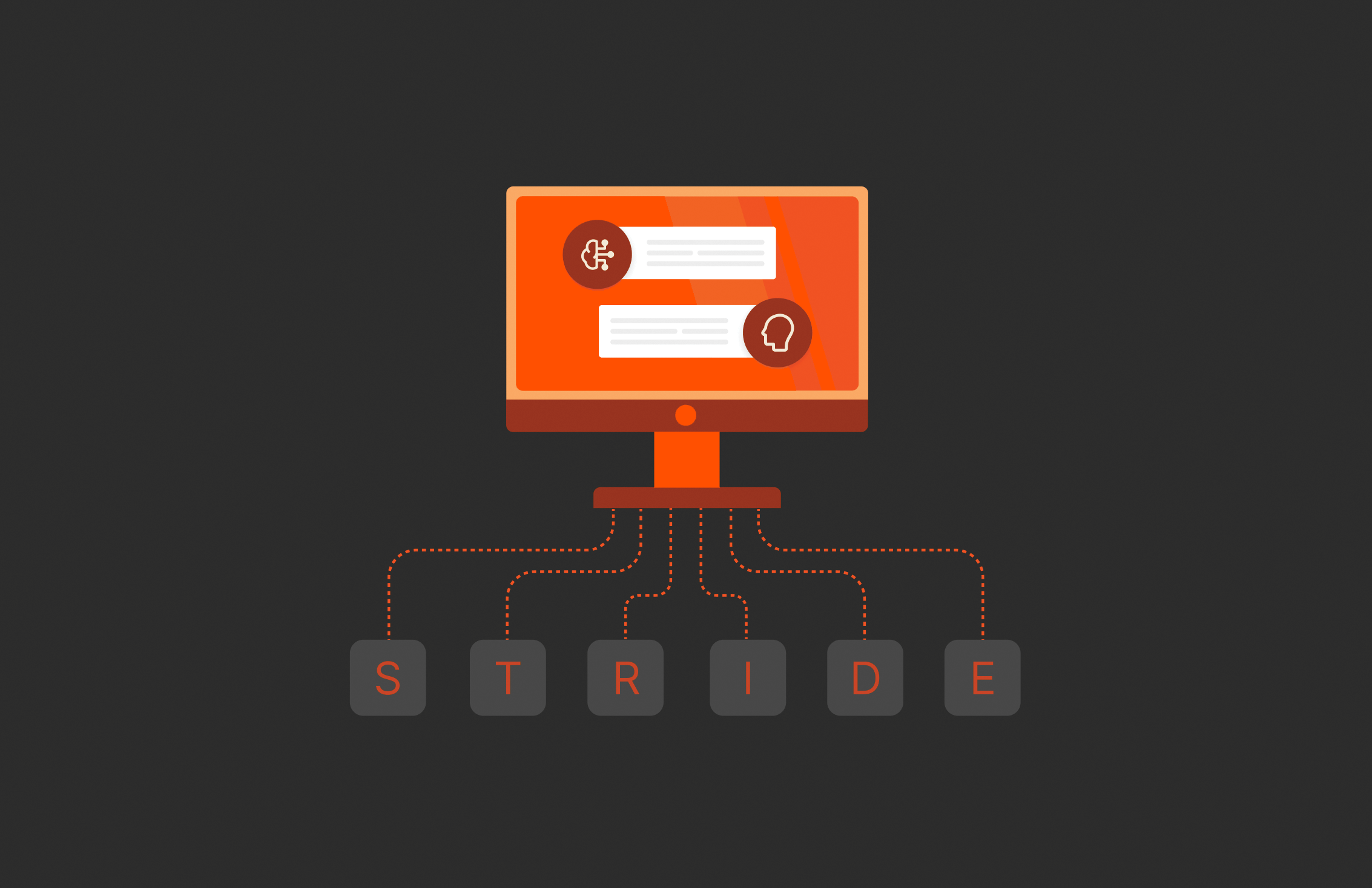

A modelagem de ameaças é uma etapa fundamental para projetar sistemas seguros, identificar vulnerabilidades e mitigar riscos. Estruturas como o STRIDE oferecem abordagens sistemáticas para categorizar ameaças, mas elas apresentam desafios significativos:

- Falta de experiência: Muitas equipes não têm acesso a profissionais de segurança qualificados em modelagem de ameaças. Essa lacuna frequentemente leva a vulnerabilidades negligenciadas, aumentando o risco de violações de dados e comprometimentos do sistema.

- Restrições de tempo: A modelagem manual de ameaças consome muitos recursos e muitas vezes atrasa os cronogramas do projeto, dificultando a integração aos ciclos de desenvolvimento em rápida evolução.

- Dificuldades de integração: O alinhamento da modelagem de ameaças com fluxos de trabalho de desenvolvimento moderno, incluindo DevOps e práticas ágeis, é um obstáculo significativo. Esse desalinhamento frequentemente leva a esforços de segurança fragmentados.

Vimos a oportunidade de criar uma ferramenta com inteligência AI que automatiza a modelagem de ameaças, fornece insights acionáveis e se integra perfeitamente aos fluxos de trabalho existentes para preencher essa lacuna.

Mentor do modelo de desenvolvimento de ameaças GPT

Nossa meta era ambiciosa, mas clara: tornar a modelagem de ameaças acessível a todos. Seja você um engenheiro de segurança experiente ou um desenvolvedor novo no conceito, o Threat Model Mentor GPT visa:

- Simplifique o processo de modelagem de ameaças.

- Capacite as equipes para identificar e mitigar riscos no início do ciclo de vida do desenvolvimento.

- Integre-se perfeitamente aos fluxos de trabalho do DevSecOps.

Para isso, combinamos recursos avançados de AI com conhecimento profundo de segurança.

1. Pesquisa e coleta de conhecimento

A base da GPT de mentor de modelo de ameaças está em estruturas de segurança estabelecidas, como:

- STRIDE: Uma metodologia para identificar ameaças relacionadas a falsificação, adulteração, repudiação, divulgação de informações, recusa de serviço e elevação de privilégios.

- OWASP: Um tesouro de práticas recomendadas para segurança de aplicativos.

- Casos de uso reais: Estudamos como a modelagem de ameaças é aplicada a APIs, microsserviços e ambientes de nuvem.

2. Projetando a arquitetura

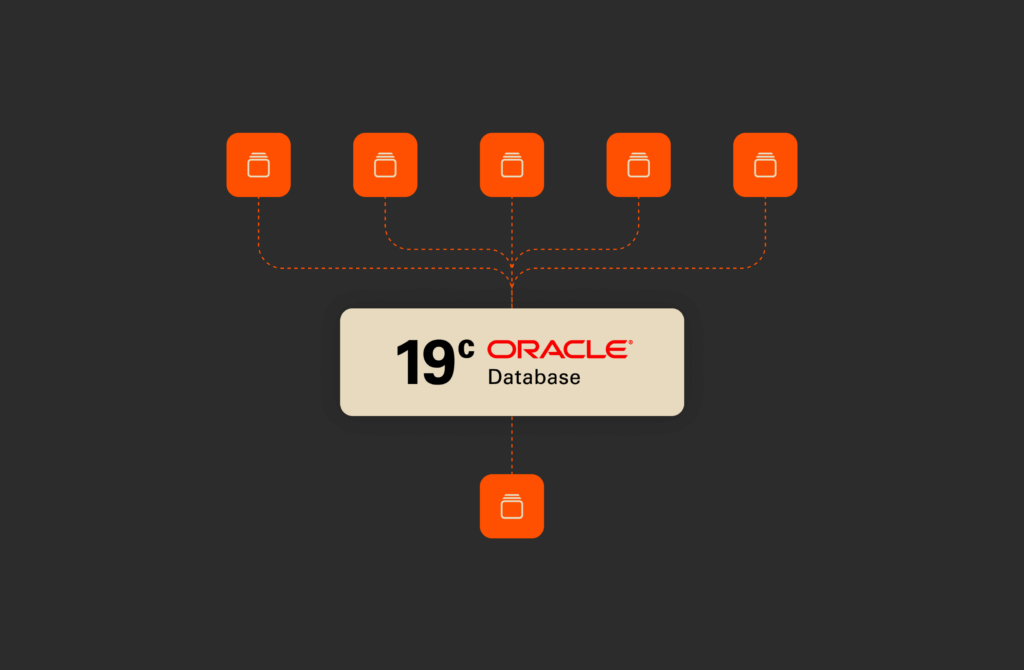

Focamos em dividir sistemas em componentes-chave:

- Limites de confiança: Onde o controle muda entre entidades, como entre um usuário e uma API

- Entidades e processos: Identificação de atores e ações no sistema

- Fluxos de dados: Mapeamento de como os dados se movem pelo sistema

O bot foi instruído a decompor esses elementos das entradas do usuário, permitindo a identificação precisa de ameaças.

3. Desenvolvimento dos principais recursos

Para oferecer o máximo de valor, desenvolvemos recursos como:

- Decomposição interativa do sistema: Os usuários podem descrever seu sistema usando uma ampla variedade de artefatos, como documentos de design, imagens de diagrama em bloco, código-fonte, scripts de implantação, etc., e a AI mapeia seus componentes e limites de ameaça.

- Categorização STRIDE automatizada: A AI aplica o STRIDE para identificar ameaças para cada componente e limite.

- Recomendações de mitigação: Consultoria prática adaptada às ameaças e ao design do sistema.

4. Integração com fluxos de trabalho de desenvolvimento

Garantimos que o Threat Model Mentor GPT pudesse se integrar a ferramentas modernas, como:

- Pipelines de CI/CD para monitoramento contínuo

- Plataformas de gerenciamento de projetos, como JIRA, para rastrear ameaças e mitigações

Resultado esperado do modelo de ameaças Mentor GPT

Quando as equipes usam o Threat Model Mentor GPT, elas podem esperar um resultado abrangente e acionável, incluindo:

| Componente de saída | Descrição | Exemplos |

| 1. Modelo de sistema decomposto | Divide o sistema em limites de confiança, entidades, fluxos de dados e processos | Entidades: Usuário, banco de dados, APIFluxos de dados: Solicitações HTTP, consultas ao banco de dadosLimites de confiança: Entre usuário e API, API e banco de dados |

| 2. Categorização STRIDE | Mapeia ameaças aos componentes do sistema com base na metodologia STRIDE | Autenticação do usuário: FalsificaçãoTransferência de dados: Registros de auditoriade adulteração: RepudiaçãoDados armazenados: Divulgação de informaçõesDisponibilidade do serviço: Negação de serviçoControle de acesso: Elevação do privilégio |

| 3. Ameaças identificadas | Lista ameaças específicas relevantes para o design do sistema | – Roubo de credenciais por meio de phishing- Modificação de dados não autorizada por meio de adulteração de API- Exposição a informações sensíveis em logs |

| 4. Estratégias de mitigação | Fornece recomendações práticas para lidar com ameaças identificadas | – Use MFA para autenticação (falsificação)- Habilite HTTPS/TLS para transferência segura de dados (falsificação)- Implemente o registro com armazenamento à prova de adulteração (repúdio) |

| 5. Priorização de riscos | Classifica as ameaças com base na probabilidade e no impacto potencial | – Alto: Vazamento de token de API – Médio: Acesso não autorizado ao banco de dados – Baixo: Sistema de registro mal configurado |

| 6. Controles sugeridos | Recomenda ferramentas ou controles específicos para melhorar a segurança do sistema | – Habilite o controle de versão do AWS S3 e o bloqueio de objetos- Use funções IAM com acesso de privilégio mínimo- Integre com um WAF para segurança de API |

| 7. Atualizações de diagrama | Representação visual do sistema decomposto com anotações atualizadas para ameaças e mitigações | Diagrama atualizado mostrando limites de confiança, fluxos de dados seguros e componentes sinalizados para análise adicional |

| 8. Orientação sobre documentação | Fornece orientação detalhada para documentar o modelo de ameaça | Recomendações de modelo para capturar ameaças, mitigações e justificativas identificadas em documentos de design ou wikis |

| 9. Próximas etapas acionáveis | Lista ações priorizadas para desenvolvedores e equipes de segurança | – Implementar limitação de taxa em APIs- Configurar criptografia de bucket S3- Programar uma revisão de acompanhamento após a implantação |

| 10. Insights educacionais | Oferece materiais de aprendizagem relacionados às ameaças e mitigações identificadas | Links para guias da metodologia STRIDE, recursos OWASP e práticas recomendadas para um design seguro de API |

Impacto do modelo de ameaça Mentor GPT

- Decomposição do sistema

- As equipes descrevem sua arquitetura de sistema, incluindo entidades, fluxos de dados e limites de confiança.

- O Threat Model Mentor GPT gera um modelo visual e mapeia ameaças potenciais.

- Identificação e mitigação de ameaças

- A ferramenta categoriza ameaças com base no STRIDE e sugere mitigações direcionadas.

- As equipes recebem recomendações como ativar a criptografia, implementar a limitação de taxa ou usar um registro à prova de adulteração.

- Priorização e planejamento

- As ameaças são classificadas por probabilidade e impacto, ajudando as equipes a se concentrarem primeiro nos problemas mais críticos.

- As equipes podem planejar tarefas de mitigação, integrá-las aos fluxos de trabalho (por exemplo, JIRA) e acompanhar o progresso.

- Integração contínua

- Ao integrar-se aos pipelines de CI/CD, o Threat Model Mentor GPT garante que a modelagem de ameaças continue sendo um processo contínuo durante todo o desenvolvimento.

- Valor educacional

- Para equipes novas na modelagem de ameaças, a AI serve como ferramenta e professora, explicando ameaças e mitigações em um formato facilmente digerível.

Veja como o Threat Model Mentor GPT já está fazendo a diferença:

- Uma equipe que projeta um aplicativo baseado em microsserviços identificou ameaças como adulteração de API e implementou mitigações em dias, economizando semanas de esforço manual.

- Desenvolvedores novos em cibersegurança aprenderam práticas recomendadas por meio das recomendações interativas da ferramenta, promovendo a colaboração com equipes de segurança.

- Ao integrar-se aos fluxos de trabalho, a ferramenta transformou a modelagem de ameaças de um gargalo em um facilitador de inovação segura.

Conclusão

A GPT do mentor de modelo de ameaças representa um salto para tornar a modelagem de ameaças acessível, eficiente e educacional. Ao combinar AI com metodologias comprovadas, desenvolvemos uma ferramenta que democratiza a experiência em cibersegurança. Seja você desenvolvedor, profissional de segurança ou gerente de produtos, o Threat Model Mentor GPT está aqui para ajudar a projetar sistemas seguros e ficar à frente das ameaças em evolução.

Em blogs subsequentes, apresentaremos aplicativos práticos do processo e da tecnologia de modelagem de ameaças assistida por AI.

ANALYST REPORT,