Dieser Beitrag wurde ursprünglich auf dieser Seite veröffentlicht.

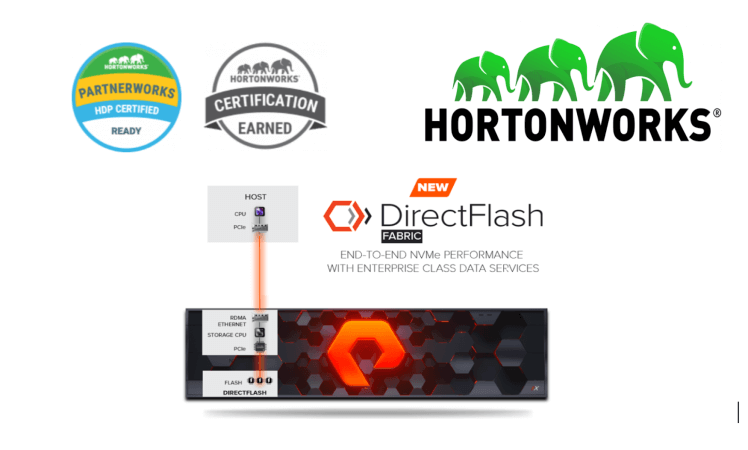

Der 19.02.2019 war ein besonderer Tag mit gleich zwei großartigen Ankündigungen: Zum Ersten kündigten wir Pure Storage FlashArray an, jetzt mit für Hortonworks Data Platform v3.0.0 zertifiziertem Storage, und zum Zweiten freuen wir uns, DirectFlash Fabric auf den Markt zu bringen, das das NVMe-oF-RoCE-Protokoll verwendet. Unsere erste Implementierung des NVMe-oF-Protokolls verwendet RoCE, was für RDMA over Converged Ethernet (RDMA = Remote Direct Memory Access) steht. FlashArray//X mit DirectFlash-Technologie liefert eine hervorragende Performance, die SAS-SSDs übertrifft.width

FlashArray Now Certified with Hortonworks Data Platform

FlashArray Now Certified with Hortonworks Data Platform

Bevor ich darauf eingehe, was diese Zertifizierung bedeutet und wie wir die Welt der Big Data verändern können, hier die kurze Geschichte von Hortonworks und der Hortonworks Data Platform (HDP).

Hortonworks:

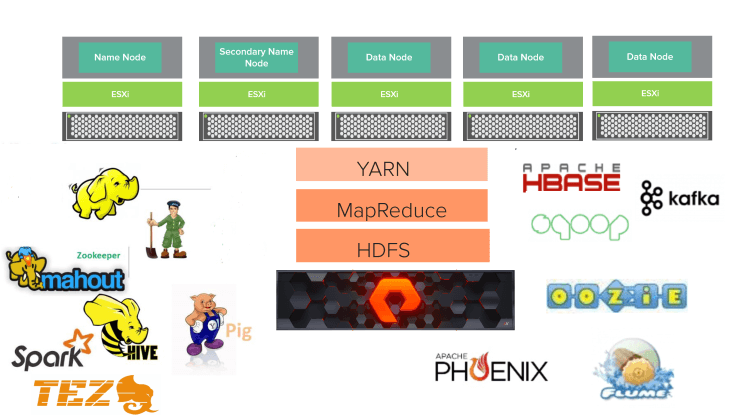

Hortonworks wurde im Juni 2011 als unabhängiges Unternehmen gegründet, finanziert durch Risikokapital in Höhe von 23 Millionen Dollar von Yahoo! und Benchmark Capital. Das Unternehmen beschäftigt Mitarbeiter am Open-Source-Softwareprojekt „Apache Hadoop“. Das Produkt Hortonworks Data Platform (HDP) umfasst Apache Hadoop und wird zum Speichern, Verarbeiten und Analysieren großer Datenmengen verwendet. Die Plattform ist für die Verarbeitung von Daten aus vielen Quellen und Formaten konzipiert. Die Plattform umfasst Hadoop-Technologie wie das Hadoop Distributed File System, MapReduce, Pig, Hive, HBase, ZooKeeper und zusätzliche Komponenten. Jetzt hat Hortonworks seine Fusion mit Cloudera im Januar 2019 abgeschlossen.

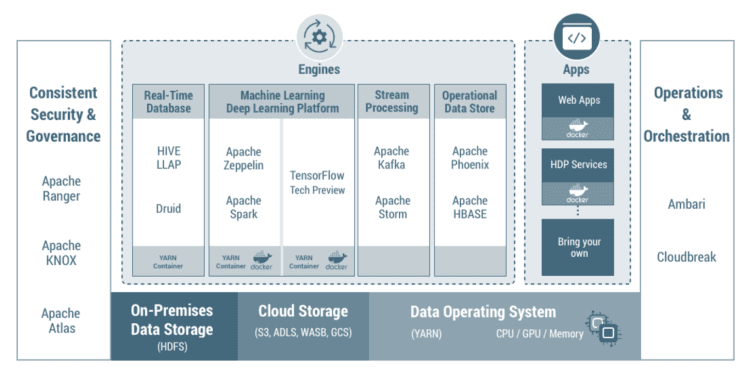

Hortonworks Data Platform:

HDP ist eine sehr beliebte Big-Data-Plattform oder zumindest war es eine der beiden beliebtesten lokalen Hadoop-Plattformen. Hadoop ist eine Sammlung von Open-Source-Anwendungen, die viele Server nutzt, um Probleme unter Beteiligung vieler strukturierter und unstrukturierter Daten zu lösen. Es handelt sich um ein Framework, das auf verteiltem Storage (HDFS) und der Verarbeitungs-Engine MapReduce basiert. HDFS zerlegt Dateien im Grunde in große Blöcke und verteilt sie auf die Datenknoten im Cluster. Dann bearbeitet HDFS die Daten in jedem Knoten parallel und reduziert den Datensatz, indem es die Daten an das Reduzierungspogramm sendet, um das endgültige aggregierte Ergebnis zu erhalten. HDP ist eine unternehmenstaugliche Open-Source-Distribution von Apache Hadoop auf Basis einer zentralisierten Architektur. HDP erfüllt alle Anforderungen von Daten im gespeicherten Zustand, treibt Echtzeit-Kundenanwendungen an und liefert zuverlässige Big-Data-Analysen, die Entscheidungsfindung und Innovation beschleunigen. Die neueste Version von HDP bietet neue Funktionen für Unternehmen an, die eine agile Anwendungsbereitstellung, neue Workloads für maschinelles Lernen/Deep Learning, Echtzeit-Data-Warehousing sowie Sicherheit und Governance ermöglichen.

Herausforderungen durch Big Data und DAS:

Eine der größten Herausforderungen bei der Arbeit mit Big Data ist das Datenwachstum. Daten wachsen ständig und oft mit sehr hoher Geschwindigkeit. Und an diesem Punkt schneidet eine SAN-Architektur, in der Sie die Rechenleistung vom Storage trennen, besser ab als herkömmliche, DAS-basierte Hadoop-Systeme. Herkömmliche DAS-Systeme sind oft sehr schwer zu skalieren und zu verwalten. Im Gegensatz dazu ist SAN extrem einfach zu verwalten und zu skalieren. Insbesondere kann das Pure Storage-FlashArray unterbrechungsfrei von einem Basismodell zu einem Modell mit höherer Kapazität und besserer Performance hin skaliert werden. Mit FlashArray//X DirectFlash Fabric übertrifft seine Performance die Performance von SAS-DAS-SSDs in Bezug auf Latenz und Durchsatz. Dieser Anspruch einer besseren Performance von FlashArray//X DirectFlash Fabric basiert auf den Tests, die wir durchgeführt haben und bei denen wir Apache Cassandra, MongoDB, MariaDB auf FlashArray//X DirectFlash Fabric und SAS-SSD-DAS verglichen haben. Im Hinblick auf Apache Cassandra haben wir herausgefunden, dass Schreib-Latenzzeiten und Operationen pro Sekunde bei Apache Cassandra auf Basis von FlashArray//X DirectFlash Fabric 30 % besser waren als bei einem Cassandra-Cluster auf SAS-SSD-DAS. Dies macht FlashArray//X zu einer sehr guten Wahl für die Hortonworks Data Platform.

Referenzarchitektur:

Zu Zertifizierungszwecken haben wir wie unten gezeigt einen Cluster aus fünf Knoten mit Pure Storage FlashArray//X mit DirectFlash Fabric erstellt. Die Knoten wurden mit VMware VSphere 6.5 und mit einem Red Hat 7.x-Betriebssystem virtualisiert. Auf diesem Fünf-Knoten-Cluster wurde der HDP 3.0.0 installiert und QATS wurde für die Zertifizierung/Tests verwendet. Im Wesentlichen ist QATS (Quality Assured Testing Suite) ein Zertifizierungsprogramm für die Produktintegration, das dazu entwickelt wurde, Software, Dateisystem, Hardware der nächsten Generation und Container mit der Hortonworks Data Platform (HDP) gründlich zu testen.

HDP 3.0.0 reference architecture

HDP 3.0.0 reference architecture

Die QATS-Suite validiert die folgenden Aspekte für die HDP-Komponenten:

- Vollständiges Funktionsspektrum

- Hochverfügbarkeit

- Sicherheitsaspekte

- Kerberos

- Ranger

Beispiel: Für MapReduce werden die folgenden Aspekte getestet:

| Funktionen | HA | Kerberos | Ranger | Wire-Verschlüsselung | Transparente Daten Verschlüsselung |

| JA | Nicht zutreffend | JA | Nicht zutreffend | NEIN | NEIN |

Funktionsszenarien:

- NN-Bench-Tool

- MR-Bench-Tool

- Terasort-Job: Input mit TeraGen generieren. Mit TeraSort sortieren.

- JHS: für einen anderen Job-Status

- Kompression: Für Wortanzahl-Jobs gibt es verschiedene Arten von Komprimierungs-Codecs für verschiedene Komprimierungsarten

- Kerberos: Die oben genannten Funktionsszenarien werden in einer Kerberos-fähigen Umgebung ausgeführt.

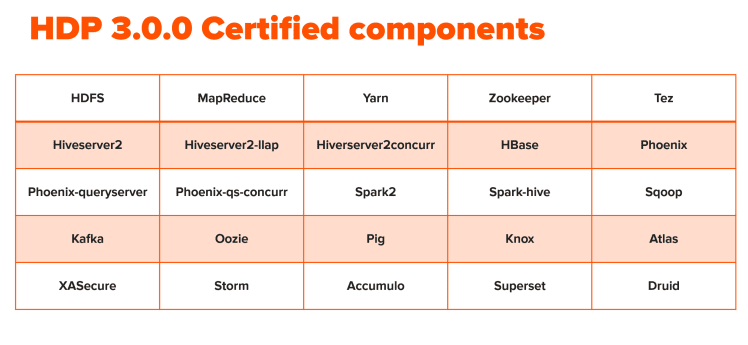

Von Hortonworks zertifizierte Komponenten:

Die folgenden Komponenten von HDP sind für die Ausführung auf FlashArray//X zertifiziert.

Nachfolgend stehen die einzelnen Komponentenversionen samt Beschreibung:

| Komponenten | Version | Beschreibung |

| HDFS | 3.1.0 | Apache Hadoop Distributed File System |

| YARN | 3.1.0 | Apache Hadoop NextGen MapReduce (YARN) |

| MapReduce2 | 3.1.0 | Apache Hadoop NextGen MapReduce (YARN) |

| Tez | 0.9.1 | Tez ist das Hadoop-Abfrageverarbeitungs-Framework der nächsten Generation, das auf YARN aufbaut. |

| Hive | 3.1.0 | Data-Warehouse-System für Ad-hoc-Abfragen und die Analyse großer Datensätze sowie Tabellen- und Storage-Verwaltungsservice |

| HBase | 2.0.0 | Nicht relationale verteilte Datenbank und zentralisierter Service für Konfigurationsmanagement und Synchronisation |

| Pig | 0.16.0 | Skripterstellungsplattform zur Analyse großer Datensätze |

| Sqoop | 1.4.7 | Tool zum Übertragen großer Datenmengen zwischen Apache Hadoop und strukturierten Datenspeichern wie z.B. relationalen Datenbanken |

| Oozie | 4.3.1 | System zur Workflow-Koordinierung und zum Ausführen von Apache Hadoop-Jobs |

| ZooKeeper | 3.4.6 | Zentralisierter Service, der eine äußerst zuverlässige verteilte Koordination bereitstellt |

| Storm | 1.2.1 | Apache Hadoop-Datenstromverarbeitungs-Framework |

| Accumulo | 1.7.0 | Zuverlässiger, skalierbarer und leistungsstarker verteilter Schlüssel-/Wertspeicher |

| Infra Solr | 0.1.0 | Service mit gemeinsam genutztem Kern, der von durch Ambari verwalteten Komponenten verwendet wird |

| Ambari Metrics | 0.1.0 | Ein System zur Messdatensammlung, das Storage- und Abruffunktionen für Messdaten bereitstellt, die aus dem Cluster erfasst wurden |

| Atlas | 1.0.0 | Atlas-Metadaten- und Governance-Plattform |

| Kafka | 1.0.1 | Ein verteiltes Nachrichtensystem mit hohem Durchsatz |

| Knox | 1.0.0 | Bietet einen einzigen Authentifizierungs- und Zugriffspunkt für Apache Hadoop-Services in einem Cluster |

| Log Search | 0.5.0 | Protokollaggregation, -analyse und -visualisierung für durch Ambari verwaltete Services. Dieser Service ist eine technische Vorschau. |

| Ranger | 1.0.0 | Umfassende Sicherheit für Hadoop |

| Ranger KMS | 1.0.0 | Schlüsselverwaltungsserver |

| SmartSense | 1.5.0.2.7.0.0-846 | SmartSense – das Hortonworks SmartSense Tool (HST) hilft bei der schnellen Erfassung von Konfigurationen, Messdaten und Protokollen aus gängigen HDP-Services, die bei der schnellen Fehlerbehebung in Supportfällen und beim Erhalt von clusterspezifischen Empfehlungen helfen. |

| Spark2 | 2.3.1 | Apache Spark 2.3 ist eine schnelle und allgemeine Engine für die Verarbeitung großer Mengen von Daten. |

| Zeppelin-Notebook | 0.8.0 | Ein webbasiertes Notebook, das interaktive Datenanalysen ermöglicht. Es ermöglicht Ihnen, ansprechende datengesteuerte, interaktive und kollaborative Dokumente mit SQL, Scala und mehr zu erstellen. |

| Druid | 0.12.1 | Ein schneller, spaltenorientierter verteilter Datenspeicher |

| Kerberos | 1.10.3-30 | Ein Computernetzwerk-Authentifizierungsprotokoll, das auf der Grundlage von „Tickets“ arbeitet, um es Knoten, die über ein unsicheres Netzwerk kommunizieren, zu ermöglichen, einander auf sichere Weise ihre Identität nachzuweisen |

| Superset | 0.23.0 | Superset ist eine visuell, intuitiv und interaktiv gestaltete Datenexplorationsplattform. Dieser Service ist eine technische Vorschau. |

Zusammenfassung:

FlashArray//X, jetzt mit DirectFlash Fabric, das NVMe over RoCE verwendet, wird einen Wendepunkt in der Welt der Big Data darstellen. FlashArray//X ist sehr einfach zu bedienen und bereitzustellen, was wiederum die Implementierung vereinfacht und die Akzeptanz fördert. Es kann unterbrechungsfrei in dem Maß skaliert werden, in dem Ihre Daten wachsen, und beschleunigt Ihre Projektzeitpläne. FlashArray//X mit DirectFlash Fabric ist für die Hadoop Data Platform 3.0.0 zertifiziert.